Ich hatte das Blog hier auf imagcon.de vor Jahren abgeschaltet, da ich keine Zeit mehr hatte, mich um neue, relevante Artikel zu kümmern. Die Zeiten sind vorbei, es wird in Zukunft wieder mehr IT-relevante Blogbeiträge geben.

Die Themenvielfalt ist hierbei potentiell groß, es gibt viel über jede Menge aktuelle Themen zu schreiben, vom Zwangsupdate auf Windows 11 oder das allgegenwärtige Schlangenöl namens „KI“, bei dem insbesondere von großen Tech-Konzernen versucht wird, Privatpersonen und Firmen KI als Allheilmittel für alles anzudrehen.

Und das ist es nicht. Es gibt eine Menge sinnvolle Anwendungen für Deep Learning-Modelle, seien es beispielsweise Krebs-Früherkennungen oder Systeme, die feststellen, ob gerade jemand im Schwimmbad ertrinkt. Aber jede Menge vollmundige Versprechungen von Altman (CEO von OpenAI, die mit ChatGPT) und Co sind einfach nur das: Vollmundige Versprechungen, Dampfblasen ohne Substanz. Das stellen auch große Firmen weltweit gerade fest: Sie haben auf irgendeinen KI-Mumpitz umgestellt, ihre Mitarbeiter zugunsten der billigen KI rausgeschmissen. das bringt sie jetzt in massive Schwierigkeiten und sie versuchen verzweifelt, die Fachkräfte zurückzugewinnen, das beste aktuelle Beispiel ist Zahlungsdienstleiter Klarna.

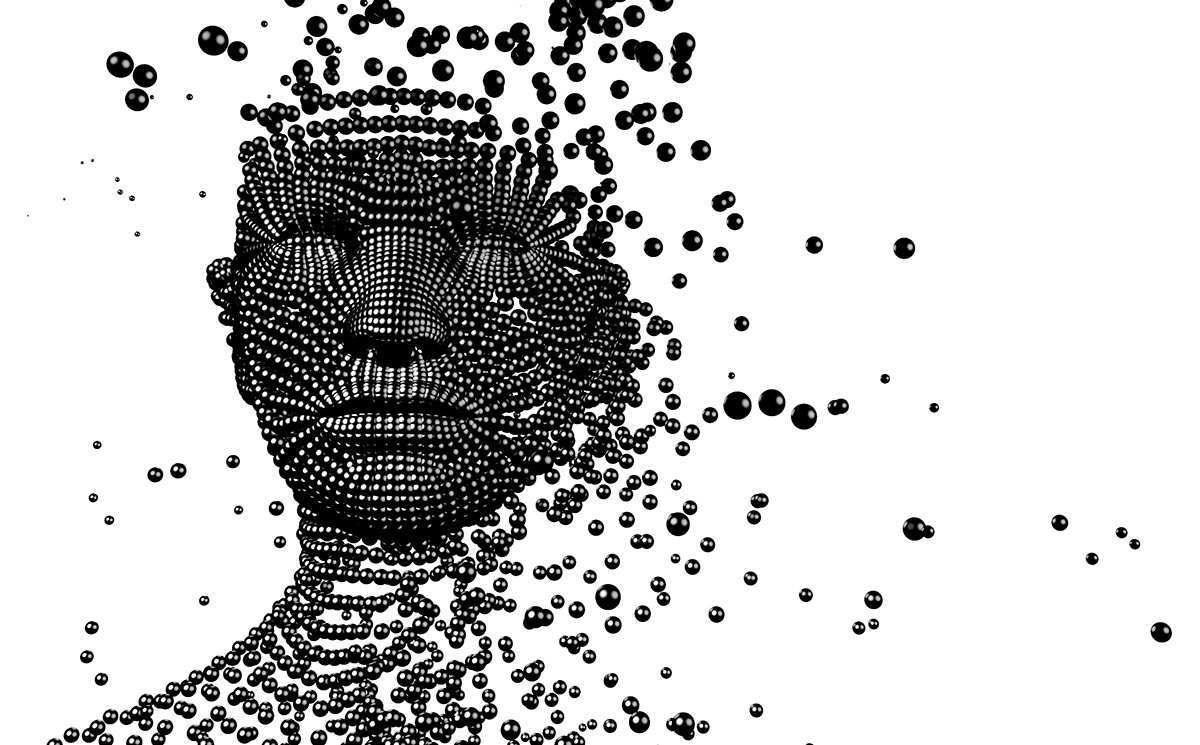

Der konkrete Anwendungsfall ist wichtig. Und gerade LLMs, also Large Language Models, sind im Prinzip nichts anderes als Kaugummiautomaten, die mit Myriaden von Kaugummikugeln gefüttert wurden und wenn man eine herauszieht, kann das die Farbe sein, die man haben wollte, oder eben nicht. Es sind glorifizierte Zufallsgeneratoren, die allzu oft falsch liegen – und man benötigt immer noch die kognitiven Fähigkeiten festzustellen, ob die KI Unsinn verzapft (also „halluziniert“), oder nicht. Dazu kommen aktuelle Studien, die belegen, dass Personen, die intensiv LLMs nutzen, ihre kognitiven Fähigkeiten dramatisch schnell verlieren – also rustikal ausgedrückt: Verblöden.

Und man muss sich auch darüber im Klaren sein, dass eine Menge von dem, was Zuckerberg, Altman und Google-Manager gerade dabei raushauen, wenn sie sich darin überbieten zu bejubeln, was ihre neuen KIs können, reine Werbeblasen sind. Waschmittelwerbung, wer noch weißer wäscht. Als Altman ChatGPT 5 in den höchsten Tönen als Genie lobte, stellte sich schon am nächsten Tag heraus, dass das alles falsch war und 5 in Aspekten schlechter war, als 4. Man sollte also alles, was die Tech-Bros so werbewirksam kolportieren sehr kritisch betrachten und als das sehen was es ist: aufgeblasene Werbung, um Schlangenöl zu verkaufen.

Es ist sicherlich spannend, dabei zuzusehen, ob und wie sich das Ganze weiter entwickelt und ob Probleme in Zukunft ausgemerzt werden. Weniger spannend ist die Tatsache, dass die Infrastruktur hinter all dem „KI“-Getue so unfassbar viel Energie verbrät, dass Microsoft und Google Atomkraftwerke kaufen wollen. Und da muss man sich schon mal die Frage stellen dürfen, ob lustige Bilder von Actionfiguren generieren oder automatisch erstellte Emails es wert sind, die Zukunft unseres Planeten aufs Spiel zu setzen. Und ebenso sollte man sich die Frage stellen, ob man tatsächlich will, dass Bundesbehörden KI-Applikationen von Trump-Anhängern wie das mit hoher Wahrscheinlichkeit grundrechtswidrige Palantir einsetzen sollten. Die eben genauso halluzinieren können, wie ChatGPT – aber ob Polizisten das dann korrekt interpretieren können (was man bezweifeln muss), darf nicht über Bürgerrechte entscheiden.

Das Thema KI ist wichtig und spannend, aber eins ist sicher: KI hat sinnvolle und wichtige Anwendungen, ist aber weder unfehlbar, noch ein Allheilmittel. In erster Linie möchten sich im Moment die US-Plattformkapitalisten damit dumm und dusslig verdienen. Und von denen muss Europa sich dringend emanzipieren und auch nicht auf ihr Schlangenöl hereinfallen.